O que é moderação de conteúdo?

A moderação de conteúdo refere-se ao processo de revisar, monitorar e gerenciar o conteúdo gerado por usuários em plataformas digitais, como redes sociais, fóruns e sites de comentários. Este processo é fundamental para garantir que o ambiente online permaneça seguro, respeitoso e livre de conteúdos prejudiciais, como discursos de ódio, spam e desinformação. A moderação pode ser realizada de forma manual, por moderadores humanos, ou automática, através de algoritmos e inteligência artificial.

Importância da moderação de conteúdo

A moderação de conteúdo é crucial para manter a integridade das comunidades online. Ela ajuda a proteger os usuários de interações negativas e a promover um espaço onde todos possam se expressar de maneira construtiva. Além disso, uma boa moderação pode aumentar a confiança dos usuários na plataforma, resultando em maior engajamento e retenção. Sem uma moderação eficaz, o conteúdo impróprio pode proliferar, prejudicando a reputação da marca e a experiência do usuário.

Tipos de moderação de conteúdo

Existem diferentes tipos de moderação de conteúdo, incluindo a moderação pré-publicação, onde o conteúdo é revisado antes de ser publicado, e a moderação pós-publicação, onde o conteúdo é monitorado após a publicação. A moderação pode ser feita de forma automática, utilizando ferramentas de inteligência artificial que identificam padrões de comportamento e conteúdo, ou manualmente, com moderadores humanos que analisam o conteúdo em busca de violações das diretrizes da comunidade.

Desafios da moderação de conteúdo

A moderação de conteúdo enfrenta diversos desafios, como a identificação de conteúdos sutis que podem violar as diretrizes, a necessidade de agir rapidamente para evitar a propagação de informações prejudiciais e a pressão para respeitar a liberdade de expressão. Além disso, a moderação automática pode falhar em contextos complexos, onde o entendimento humano é necessário para interpretar nuances e intenções. Esses desafios exigem uma abordagem equilibrada entre tecnologia e intervenção humana.

Ferramentas de moderação de conteúdo

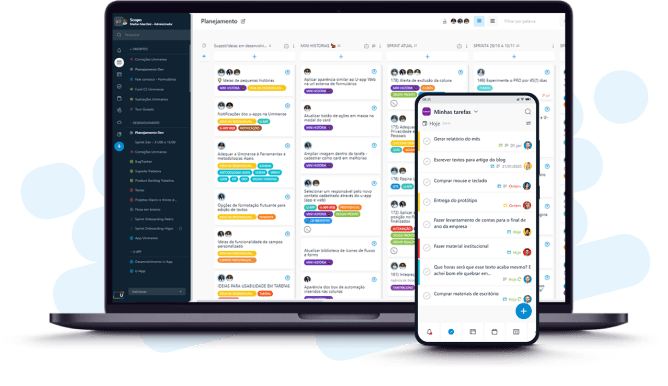

As ferramentas de moderação de conteúdo variam desde softwares de filtragem automática até plataformas de gerenciamento de comunidade que permitem a interação entre moderadores e usuários. Essas ferramentas podem incluir algoritmos de aprendizado de máquina que analisam o conteúdo em tempo real, sistemas de relatórios que permitem que os usuários sinalizem conteúdo problemático e painéis de controle que ajudam os moderadores a gerenciar e revisar o conteúdo de forma eficiente.

Políticas de moderação de conteúdo

As políticas de moderação de conteúdo são diretrizes que definem o que é aceitável e o que não é em uma plataforma. Essas políticas devem ser claras, acessíveis e frequentemente atualizadas para refletir as mudanças nas normas sociais e nas expectativas dos usuários. Uma política bem elaborada ajuda a orientar os moderadores em suas decisões e a educar os usuários sobre o que é esperado em termos de comportamento e conteúdo.

Impacto da moderação de conteúdo na experiência do usuário

A moderação de conteúdo tem um impacto direto na experiência do usuário. Quando realizada de forma eficaz, ela cria um ambiente mais seguro e acolhedor, incentivando a participação e o engajamento. Por outro lado, uma moderação excessiva pode levar à frustração dos usuários, que podem sentir que suas vozes estão sendo silenciadas. Portanto, é essencial encontrar um equilíbrio que permita a liberdade de expressão enquanto se protege a comunidade de conteúdos prejudiciais.

O papel da inteligência artificial na moderação de conteúdo

A inteligência artificial desempenha um papel crescente na moderação de conteúdo, oferecendo soluções que podem analisar grandes volumes de dados em tempo real. Algoritmos de aprendizado de máquina são utilizados para identificar padrões de comportamento e classificar conteúdos de acordo com suas diretrizes. No entanto, é importante lembrar que a IA ainda não é perfeita e deve ser complementada por revisões humanas para garantir a precisão e a sensibilidade nas decisões de moderação.

Futuro da moderação de conteúdo

O futuro da moderação de conteúdo provavelmente será marcado por avanços tecnológicos, incluindo melhorias na inteligência artificial e na análise de dados. À medida que as plataformas digitais evoluem, a moderação de conteúdo também precisará se adaptar, abordando novos tipos de desafios e ameaças. A colaboração entre tecnologia e moderadores humanos será fundamental para criar um ambiente online seguro e inclusivo, onde todos possam se expressar livremente.